1、概述

-

LDA与QDA可以简单理解为有监督的降维,将多个预测变量信息压缩成少数(类别数-1)新的预测变量。

-

每一个新的预测变量称之为判别函数,由所有原始变量的线性组合。

所以对类别区分贡献大的变量具有绝对值最大的系数(也称为标准判别函数系数),而包含很少或者不包含类别分离信息的变量的系数约等于0

-

在分类时,表现最好的是第一个判别函数,其次是第二个…以此类推。

-

LDA(Linear discriminant analysis),为线性判别分析,可以学习不同类别之间的线性的决策边界;

-

QDA(Quadratic discriminant analysis),为二次判别分析,可以学习不同类别之间的曲线的决策边界

-

LDA与QDA均假设所有预测变量呈正态分布;LAD则进一步假设数据集里每一个类别,预测变量之间具有相同的协方差;而QDA没有这一假设。

协方差可以简单理解为变量之间的相关性。

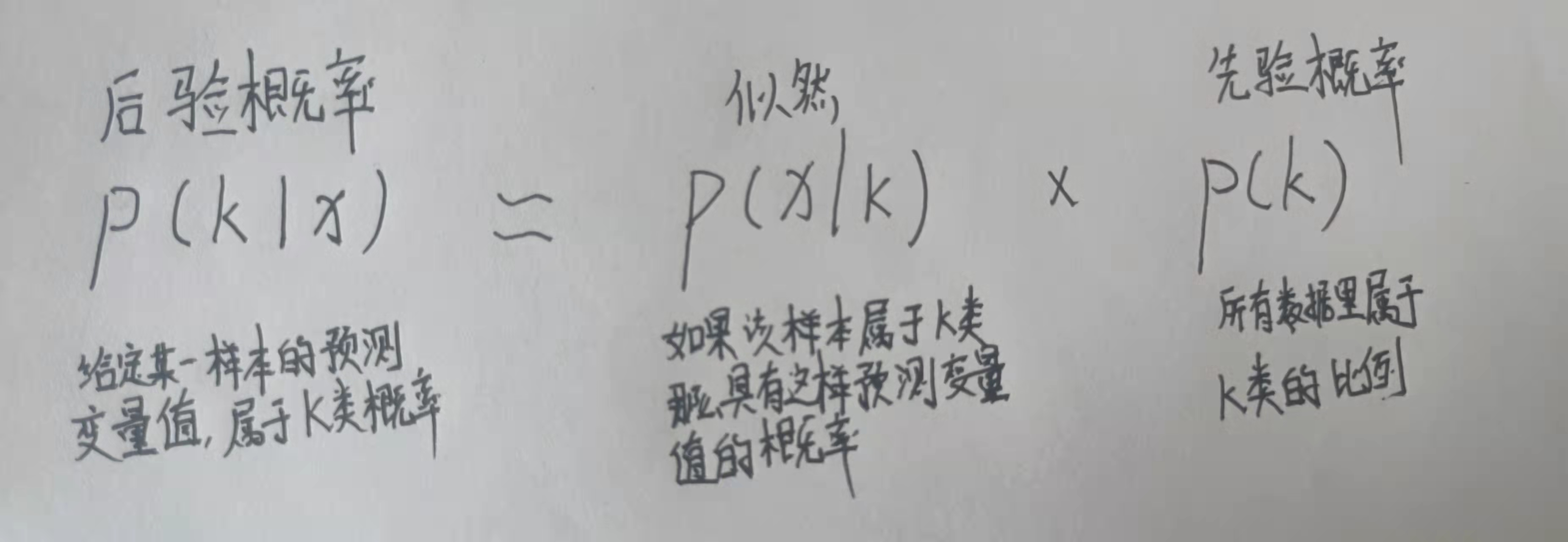

- 在分类预测时,使用贝叶斯准则预测属于每一种类别的概率,选择概率最大的类别。

2、mlr建模

2.1 葡萄酒数据

|

|

2.2 确定预测目标与训练方法

|

|

2.3 模型训练、预测

(1)LDA模型

|

|

|

|

(2)QDA

|

|

注意到LDA与QDA的预测结果并不一致。下面通过交叉验证哪一种模型的性能更好一些。

2.4 交叉验证

- LDA

|

|

- QDA

|

|

如此看来,还是QDA的性能更好一些,但也容易过拟合。